IT存储网络运维 | InfiniBand技术简介

2020-04-09 09:15 作者:艾锑无限 浏览量:

IT存储网络运维 | InfiniBand技术简介

我们经常听到关于某超算中心架构又用了什么先进的技术,而在这些技术中,InfiniBand技术则是人们谈论最多的话题。那么InfiniBand到底有多牛? 简单来说,InfiniBand是一种支持多并发链接的转换线缆技

术,它既可以处理存储I/O、网络I/O,也能够处理进程间通信(IPC),这样它即可以将磁盘阵列、SANs、LANs、服务器和集群服务器进行互联,也可以连接外部网络(比如WAN、VPN、互联网)。

1、InfiniBand技术背景和现状

设计InfiniBand的目的主要是用于企业数据中心,大型的或超大型的数据中心,为了实现高的可靠性、可用性、可扩展性和高的性能。并且InfiniBand可以在相对短的距离内提供高带宽、低延迟的传输,而且在单

个或多个互联网络中支持冗余的I/O通道,因此能保持数据中心在局部故障时仍能运转。Infiniband网络是一种高带宽低延时的网络,相比传统的以太网络,最新一代的Infiniband网络带宽可达100Gbps,点到点的

延时低于0.6us。Infiniband网络主要用于高性能计算场景,通过高速的Infiniband网络,将一台台多路服务器构建为一个高性能计算集群,集群性能基本上是单台服务器性能的线性叠加,可以说正是因为有

Infiniband网络技术,才能催生出超算高性能集群架构。Infiniband交换机可以分别带管理交换机和不带管理交换机,带管理交换机有硬件管理端口,对整个网络的管理可以通过交换机硬件完成,通常一个项目中

会配置少量的带管理交换机(两台)。

2、InfiniBand为超算中心提供超强传输性能

有鉴于此,越来越多的超算中心开始大量采用InfiniBand技术,尤其是在对传输性能要求非常高的数据中心中,应用非常广泛。近日,全球知名的InfiniBand解决方案提供商Mellanox公司市场副总裁Gilad Shainer

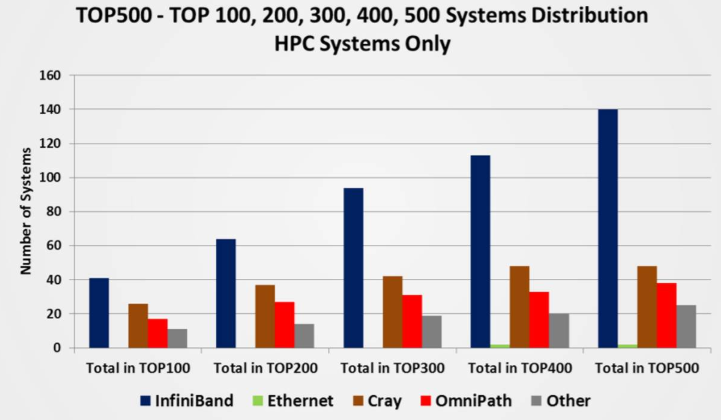

先生接受了记者专访时,详细阐述了InfiniBand 解决方案的市场竞争力及为全球用户企业提供的全新性能和可扩展性。当今超算TOP500的排名中,在Intersect360调查中,约2/3的受访系统上部署安装了以太网和

InfiniBand。这显示,InfiniBand解决方案依然在高性能计算领域占有着绝对的市场份额,远远高于高性能计算系统里面的其他网络互联厂商。

Mellanox的InfiniBand的解决方案占据了近一半的市场份额,高达46%的份额,这充分例如显示了在高性能计算系统里面Mellanox的网络依然是一个绝对领先的高速网络。而在2016年TOP500里面新建的系统中,

有65个选择了Mellanox的产品,在2019年最新TOP500列表中,InfiniBand份额为28%(140个系统)。但是,从性能的角度来看,基于InfiniBand的计算网络占TOP500总体性能的40%

3、InfiniBand技术玩家和如今巨头

InfiniBand Trade Association (IBTA)的9个主要董事成员中只有Mellanox和Emulex专门在做InfiniBand,其他成员只是扮演了使用InfiniBand的角色。而Emulex由于业务不景气也在2015年的2月被Avago收购,

Qlogic的infiniband业务在2012年也全部卖给Intel了,Intel基于此布局OPA。Mellanox在InfiniBand市场一家独大,其产品的集群部署数量远远大于选择竞争对手的数量,选择Mellanox产品的集群数量是选择竞争

对手Omni-Path(英特尔)网络的近四倍,是另外一个竞争对手Cray系统的五倍。Mellanox公司提出Co-design(协同设计)理念,基于任务卸载(Offloading)的架构能够让像RDMA(远程内存直接访问)这样的技术变

得可用,而这传统的数据中心加载(Onloading)架构无法做到的。而且采用智能的互连和卸载技术,可以让高性能计算系统继续扩展下去。

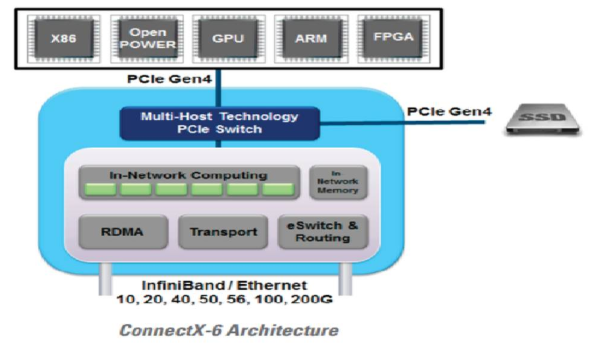

为了让网络来协助处理数据,Mellanox不断去开发智能网络,在2019年11月份,Mellanox发布了全球首个 200Gb/s 数据中心网络互连解决方案。Mellanox ConnectX-6 适配器、Quantum交换机、 LinkX线缆和收

发器一同构成了面向新一代高性能计算、机器学习、大数据、云、web 2.0和存储平台的完整 200Gb/s HDR InfiniBand 网络互连基础设施。

ConnectX-6改进了Mellanox的多主机技术,允许最多8台主机连接到一个适配器将PCIe接口分割成多个独立的接口。降低了通过减少资本支出(线缆、NIC和交换机端口)和运营成本(减少交换机端口费用)。

Mellanox多主机技术可用于Mellanox ConnectX10/25/40/50/100千兆以太网和VPI(虚拟协议互联)适配器、定制卡和基于OCP主板。200Gb/s HDR InfiniBand 解决方案进一步巩固了Mellanox的市场领先地位,同时

使客户和用户能充分利用基于开放标准的技术,最大程度的提升应用程序的性能和可扩展性,同时极大降低数据中心的总体拥有成本。Mellanox 200Gb/s HDR InfiniBand Quantum 交换机是全球最快的交换机,

支持 40 端口的 200Gb/s InfiniBand 或 80 端口的 100Gb/s InfiniBand 连接,可实现 16Tb/s 的总交换处理能力,且延迟极低,仅有 90ns(纳秒)。Mellanox Quantum 交换机拥有市场上可扩展性最强的交换芯片,

提升了对网络内计算(in-network computing)技术的支持,并经过优化且灵活的路由引擎。为了打造完整的端到端 200Gb/s InfiniBand 基础架构,Mellanox还将发布最新的LinkX 解决方案,为用户提供一系列不同

长度的 200Gb/s 铜缆及硅光线缆。

以上文章由北京艾锑无限科技发展有限公司整理

相关文章

关闭

关闭